ИИ слушает: Вездесущие робомодераторы - новейшая стратегия борьбы с токсикозом в Интернете

"Токсичность" - одно из немногих слов, определяющих современную интернет-культуру, и для создателей онлайн-игр это, пожалуй, даже более серьезная проблема, чем борьба с мошенничеством. Созданы взводы офицеров доверия и безопасности, а более 200 игровых компаний, включая Blizzard, Riot, Epic Games, Discord и Twitch, присоединились к "Альянсу честной игры", где они делятся записями о своей борьбе за то, чтобы заставить игроков быть вежливыми друг с другом.

Однако, несмотря на все их усилия, в отчете 2023 года, подготовленном по заказу Unity, делается вывод, что "токсичное поведение в онлайн-играх растет". Теперь некоторые компании обращаются за решением проблемы к самым популярным новым технологиям: машинному обучению и генеративному ИИ.

На мартовской конференции разработчиков игр 2024 я пообщался с двумя производителями программного обеспечения, которые подходят к проблеме с разных сторон.

Рон Кербс - глава компании Kidas, которая производит ProtectMe, программу родительского контроля, подключаемую к компьютерным играм и передающую голосовые, текстовые чаты и даже внутриигровые события в алгоритмы машинного обучения, призванные отличить хулиганство и разжигание ненависти от игривого шутовства, а также выявить опасное поведение, такое как передача личной информации. Если программа обнаруживает проблему, она предупреждает родителей о том, что им следует поговорить с ребенком.

Однако не обязательно быть восьмилетним игроком Roblox с обеспокоенными родителями, чтобы обнаружить, что за вами следят робомоды. Kidas также делает бота ProtectMe Discord, который заходит в голосовые каналы и предупреждает человеческих модов, если обнаруживает нечестную игру. На GDC я также пообщался с Марией Лаурой Скури, вице-президентом по лабораториям и целостности сообщества в ESL Faceit Group, которая уже несколько лет использует "ИИ-модератора" под названием Minerva для обеспечения соблюдения правил на 30-миллионной эспортивной платформе Faceit.

"Наша идея заключалась в том, что если мы посмотрим на спорт, то обычно в матче есть судья", - говорит Скури. "Это человек, который как бы модерирует и следит за соблюдением правил. Очевидно, что невозможно представить, чтобы каждый матч модерировал человек, потому что у нас сотни тысяч одновременных матчей. Тогда мы создали Minerva и стали думать: "Хорошо, как мы можем использовать искусственный интеллект для модерации и устранения токсичности на платформе?"".

По словам Скури, в Faceit по-прежнему работает "много" модераторов-людей, и Minerva призвана дополнять, а не заменять человеческие суждения. Однако она имеет право самостоятельно принимать меры: Все, что Minerva делает правильно в 99 % случаев, они готовы позволить ей применять самостоятельно, а для 1% вероятности ложного срабатывания существует процесс апелляции, рассмотренный человеком. Если Minerva с большей вероятностью ошибается, ее наблюдения сначала отправляются человеку на проверку, а затем решение возвращается в модель ИИ для ее улучшения.

Последние новости

10.04.2025 :

Создатель игры Balatro, LocalThunk, хочет добиться того, чтобы Blue Prince была отмечена на The Game Awards: 'Geoff my man I better see Blue Prince as a GOTY nominee'

10.04.2025 :

Создатель игры Balatro, LocalThunk, хочет добиться того, чтобы Blue Prince была отмечена на The Game Awards: 'Geoff my man I better see Blue Prince as a GOTY nominee'

10.04.2025 :

Нет никакого иска против Списка I: В то время как негативные отзывы в Steam накапливаются, издатель симулятора наркоторговца обращается с публичной мольбой о мире

10.04.2025 :

Нет никакого иска против Списка I: В то время как негативные отзывы в Steam накапливаются, издатель симулятора наркоторговца обращается с публичной мольбой о мире

09.04.2025 :

Как хардкорная игра на выживание превратилась в градостроительный конструктор с открытым миром, где вы играете за пилота корги-мехов

09.04.2025 :

Как хардкорная игра на выживание превратилась в градостроительный конструктор с открытым миром, где вы играете за пилота корги-мехов

09.04.2025 :

Я никогда не интересовался, что такое Clair Obscur: Expedition 33, а за названием скрывается какая-то безумная ролевая история.

09.04.2025 :

Я никогда не интересовался, что такое Clair Obscur: Expedition 33, а за названием скрывается какая-то безумная ролевая история.

08.04.2025 :

Великолепная градостроительная игра Against the Storm пополнит свой состав DLC летучими мышами, которые "гордятся тем, что выносят то, что ломает других, и не выносят, когда им оказывают предпочтение".

08.04.2025 :

Великолепная градостроительная игра Against the Storm пополнит свой состав DLC летучими мышами, которые "гордятся тем, что выносят то, что ломает других, и не выносят, когда им оказывают предпочтение".

08.04.2025 :

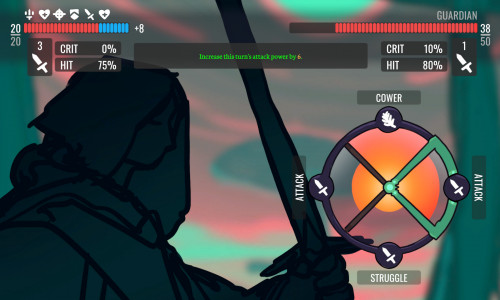

Игровой джем, основанный на ужасном колесе убеждения Oblivion, на самом деле породил несколько хороших и странных идей.

08.04.2025 :

Игровой джем, основанный на ужасном колесе убеждения Oblivion, на самом деле породил несколько хороших и странных идей.

07.04.2025 :

Ремастер классической игры D&D Neverwinter Nights 2 еще не анонсирован, но уже прошел проверку в Steam Deck.

07.04.2025 :

Ремастер классической игры D&D Neverwinter Nights 2 еще не анонсирован, но уже прошел проверку в Steam Deck.

07.04.2025 :

YouTube начал ограничивать видео Balatro по возрасту за якобы связанное с азартными играми содержание, и создателю LocalThunk явно надоели подобные вещи.

07.04.2025 :

YouTube начал ограничивать видео Balatro по возрасту за якобы связанное с азартными играми содержание, и создателю LocalThunk явно надоели подобные вещи.

06.04.2025 :

Основатель Arkane Рафаэль Колантонио отказался от ремейка System Shock, потому что киберпространственные сцены были "слишком сложными", и я не могу передать словами, насколько я сейчас разочарован.

06.04.2025 :

Основатель Arkane Рафаэль Колантонио отказался от ремейка System Shock, потому что киберпространственные сцены были "слишком сложными", и я не могу передать словами, насколько я сейчас разочарован.